大哲学罗素很早就说过,怀有各种各样愚蠢的见识乃是人类的通病,无论认知能力高低,凡人皆有偏见。于是,不少人开始把“纠偏”的希望寄予到人工智能身上。多数人相信,凭借科学的算法,机器人能够做到我们人类做不到的中立和公正,成为科技时代的新包公。殊不知,虽然1+1只能等于2,数学的世界看似非黑即白,其实,数据科学家们无法摆脱的无意识偏见,也会被微妙地过滤到算法内部。

举几个例子吧,2016年,微软新研发的人工智能聊天机器人在Twitter上线刚一天,就因为言论不当被公司强制下线,这款聊天机器人不但辱骂用户,还发表了种族主义评论和煽动性的政治宣言。不仅如此,当我们搜索CEO的图片时,还会看到机器对于性别的偏见,因为搜索结果中,白人男性的比例要比女性或其他有色群体高得多。而波士顿大学的研究人员发现,机器习惯于将“程序员”这个词和“男人”联系在一起,而女人被联系最多的词语,则是家庭主妇。

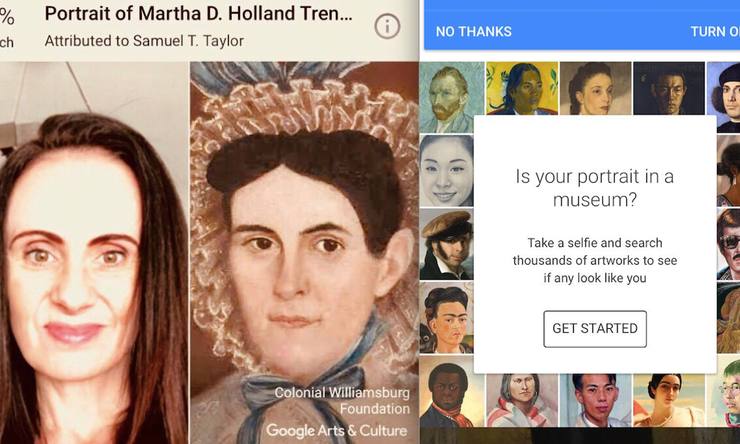

还有最近火起来的,帮你找到和你最像的名画人物的谷歌app Arts & Culture,不少非白人用户抱怨,他们的自拍,常常会和艺术作品中的奴隶、仆人联系在一起,同时,也有不少女性用户,发现自己出现在了那些将女人性别化或物化的艺术作品当中。不过,谷歌的发言人表示,这要归罪于艺术史,因为,历史上的这些艺术作品,往往不能反映世界的多样性,更别说政治正确了。而谷歌唯一能做的,就是努力上传更多,不同时期的艺术作品,使得数据库本身更加多样。

不过,即便这是历史遗留问题,算法不仅无法使用户免受种族的偏见,反而有意无意的吸收学习,甚至放大了偏见,因为不管原始代码多么纯净,机器总是很容易复制它所看到和接触到的来自世界的敌意和偏见。谷歌这回在图像识别方面摔跟头早已不是第一次,前几年,他们的图像识别技术就曾把一对黑人男女认定成大猩猩,引发极其严重的公关危机。MIT的研究人员乔伊.卜拉维尼(Joy Buolamwini)是一个黑人姑娘,她曾经发现自己带着白色面具,和用本人肤色接受电脑的图像识别时,呈现的结果完全不同,卜拉维尼还讲到这样一个真实的故事,一个亚裔新西兰人,他的护照照片被政府拒绝,因为,电脑认为他的眼睛是闭着的,而其实,他只是眼睛比较小而已。卜拉维尼之后创办了算法正义联盟(Algorithmic Justice League),这个联盟的工作方向,就是防止人类的偏见被编码植入到软件中。

想要解决这一问题,看来最简单有效的办法就是培训程序员,这样他们就不会无意中编写代码或使用带有偏见的数据。然而,在软解编写阶段,中立也是很难达到的,比如,Beaty.AI发现,让机器来做选美评审的时候,人工智能系统的结果是--所有获胜者都是白人,当开发人员意识到问题的时候,才明白,在为这台机器编写软件时,它根本就没有被设计出能够识别深色皮肤的功能。

所以,这当然不能怪人工智能,而要怪我们自己。人类自诞生以来,在演化进程中,就一直充斥着偏见,不管是出于负面情绪还是人性弱点,所有这些都会体现在人类文化中。而文化的载体就是语言,所以,所有的偏见都可以从语言和语义中找到根源。因此,为了从源头上解决问题,佐治亚理工学院,互动计算学院的副教授Mark O. Riedl提出了一个很有吸引力的解决方案--让机器人多读书。他解释说,强大而正确的价值观是可以通过学习获得的,文学作品是用隐式和显式的社会文化知识编码而成的,科学家可以在机器人中建立一个道德基础,让他们通过学习掌握是非曲直,从而学会在不伤害人类的情况下完成自己的工作。

不过,目前对于解决人工智能偏见的问题还多停留在讨论阶段,可以说,人工智能距离我们想象中的完美,还有很长的路要走。不过,人工智能开发人员至少可以更积极地发挥作用,以确保减少无意中产生的偏见。而我们每个人,更应该以身作则,在互联网世界谨言慎行,才能创造一个由人工智能辅助下的,更美好的科技未来。

作者 陈一佳 (路透社主持人|央视著名财经评论员|三橙传媒创始人)

声明:本文内容和图片仅代表作者观点,不代表蓝时代网立场。蓝时代 » 别怪人工智能变坏了,而是跟他说话的你没安好心

蓝时代

蓝时代