我们知道,人工智能的目标之一就是让计算机模拟人类的视觉、听觉、触觉等感知能力,尝试去看、听、读,理解图像、文字、语音等,在此基础上,再让人工智能具有思维能力、行动能力,最终成为跟人类一样的存在。

现在,人工智能机器人的感知能力已经实现了明显的进展。围绕机器视觉,机器人可以实现一系列像图像识别、目标检测和文字识别等功能得到广泛应用;围绕自然语言处理,机器人可以进行基本的语音理解、机器翻译、语音对话等;围绕机器触觉,机器人可以实现灵活的物体感知、抓握推举等各种动作。

单一感知或者说感知能力无法互通,成为当前人工智能机器人无法实现类人化突破的一大原因。也就是说,在单一感知能力和单一工作上,机器人的准确度、稳定性和持久性上面,可能远超人类,但一旦在完成多道工序的复杂任务上面,机器人就远逊于人类的表现。

人工智能机器人想要实现质的发展,就必须在感官能力上面实现多模态的感知融合。现在除了在我们熟知的机器视觉方面,人工智能机器人正在机器触觉和听觉方面实现突破,并且通过视觉、触觉和听觉的感知融合,来大幅提升机器人的感知能力。

对于人工智能机器人,普通人要么抱有很高的不切实际的幻想,担心机器人革命会很快到来,要么对机器人的通用能力保持怀疑,觉得机器人只能在少数场景替代人类。

只有深入到人工智能机器人的“案发现场”,不吹不黑地看下机器人感知能力的发展状况,才能知道当前机器人的感知补全计划的真正进展。

机器视觉和机器触觉

作为地球上最有智慧的生物的人类,感官获取信息的83%来自视觉,11%来自听觉、3.5%来自嗅觉,而1.5%来自触觉,1%来自味觉。

在这五种感官中,如果你不幸地只能保留一种,可能大部分都会保留视觉。要知道我们大脑的近1000亿个神经元,大多数都在处理视觉信息。而在所有的感知信息中,也只有动态的视觉信息是最为复杂的,以至于人类得靠着闭上眼睛主动隔离才能叫“休息”。

正因为视觉信息的重要和复杂,我们在人工智能技术的发展上,除了自然语言处理,那就主要在发展机器视觉了。

这一次人工智能的浪潮也是因为在图像识别上的突破进展才重新兴起。如今,机器视觉已经在工业、安防、日常消费电子、交通等各个领域全面开花,越来越多的摄像头背后都具有了AI的图像识别能力。

对于大多数人工智能机器人而言,除了有视觉能力,还有就是移动行走和抓取能力,这就需要用到触觉的帮助。对于往往只有单一功能的自动化机器人,通常只需设定好固定的参数、移动轨迹和抓取力度,即可不休不眠地完成工作任务。但对于人工智能机器人而言,则要灵活适应各种不同材质、不同形状和软硬度的物体,这个时候就既需要机器视觉的识别能力,也需要对于物体的触觉判断。

之前,大部分机器人的抓握解决方案都是单靠机器人的视觉感知。主要的解决办法就是通过数据库进行图像匹配,将目标物体的状态和自身动作进行实时监测,最终调整合适的抓取算法,来完成物体的抓取,但是有关抓握的接触力度,则是机器视觉无法代替的,这样机器还需要触觉上的感知数据。

就如同人类一样,我们在尝试抓取物体时,会组合运用各种感知能力,最基础的就是视觉和触觉。由于视觉会因为光线、阴影、视线遮挡等因素,造成误判,我们通常会更有效地利用皮肤的触觉,来获得对于物体完整的感知。

人体的触觉感知也是一个非常复杂的生物电信号反应的过程,那么要赋予机器以触觉能力也需要经过非常复杂的处理。模拟人体的触觉反应,机器人的触觉传感器也必须能够将物体的质地、光滑程度以及物体形态进行数字模拟处理,将压力和振动信号变成可以计算机处理的数据信号,从而进行触觉算法的训练。

机器触觉的难点在于对于触觉传感器获得的抓握等微小振动的识别,要能够识别抓握物体发生的滑动振动和物体与其他物体摩擦发生的振动,还要能够区分不同物体的振动,这些是研究者们重点攻克的难点。

实现突破的方法就是,我们需要更好的触觉感应器,必须做到比现有的压力传感器更好的触觉传感器,能够嵌入到柔性材料当中,实现像人类皮肤一样的人造皮肤。

最近新加坡国立大学的两名研究人员就开发出一种人造皮肤,搭载在一个能够模拟生物神经网络人造大脑,通过英特尔Loihi的神经拟态处理器上运行。在这一技术基础上,研究团队通过了机械手臂读取盲文的测试,同时借助视觉传感器和这一人造皮肤,机械手臂的抓取能力也得到明显提高。未来基于这种触觉能力的机器人,可以在物品分拣过程中做到更加灵活、细致和安全,在护理行业上,可以对人类进行更好的看护和帮助,在外科手术机器人上,更好的完成手术的自动化。

视觉和触觉的结合,已经可以为机器人感知提升提供了可能,那么听觉能力的融合,会带来哪些效果呢?

机器听觉的补全

这里的机器听觉,不是特指对于人类语音的识别。这类语音识别已经在各类消费级的智能音箱等领域得到广泛应用。这里的机器听觉是指通过声音传感器对于一切物体发出声音的判断。

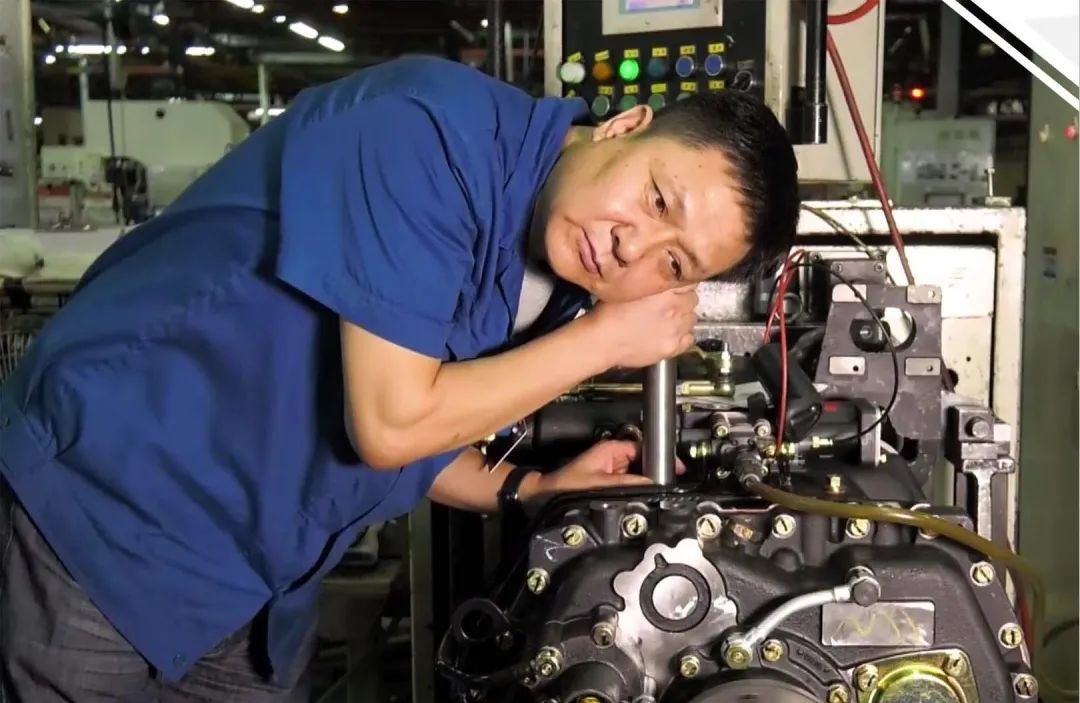

(重卡变速箱听力诊断)

相比较机器视觉对于物体的判断的简单直接,机器听觉确实是人们一直忽略的领域。在我们的日常生活场景中,我们其实除了用视觉来判断物体的远近、颜色和大小之外,我们通常也会用到听觉来识别物体的距离远近、质地,推测事件的发生。这一点对于有视力障碍的人来说尤为重要。

最近,卡内基·梅隆大学(CMU)的研究人员发现,通过增加听觉感知,人工智能机器人的感知能力可以得到显著的提高。

这一次CMU机器人研究所首次对声音和机器人动作之间的相互作用进行大规模研究。研究人员发现,不同物体发出的声音可以帮助机器人区分物体,比如金属螺丝刀和金属扳手。机器听觉还可以帮助机器人确定哪种类型的动作会产生声音,并帮助它们利用声音来预测新物体的物理属性。经过测试,机器人通过听觉在对物体进行分类的准确率能达到76%。

为了实现这一测试,研究者通过60个常见物体在一个机器人的托盘上进行滑动、滚动和撞击,记录下15000个交互的视频和音频,形成了一个大数据集。

此外,研究者还可以通过摇晃容器或者搅拌物质的声音来预估颗粒状物质的数量和流量,比如对大米和意大利面进行评估。显然,通过声音的对比,可以预测很多通过视觉无法预测的物理属性。

机器听觉无法区分一个红色方块和一个绿色方块,但他可以在看不见的情况下的撞击声,来区分出两个不同物体。而这正是机器听觉的有用性所在。最终对于声音识别物体的效果,就连研究者也都非常惊讶。

在机器听觉的应用方面,研究者首先想到的是在未来机器人的装备仪器上加一个手杖,通过手杖敲击物体来识别物体,这倒是一个有趣的画面。但可以想见,在未来智能安防、管道线路检测以及身体检测等方面,机器听觉可以发挥更大的作用。另外,对于识别最有意义的人类声音,比如音乐、情感等声音内容上面,这些应用就更加广泛。

机器人多模态感知融合的应用前景

正如感觉器官对于人类的重要性而言,感知系统对于机器人的重要性同样至关重要。

要知道,我们人类其实是很少只用一个感官去获取信息,也很少只用一个感官去指导行动。就好像在一场“攀爬-赛跑-游泳”的三合一比赛中,我们在单一项目中可能无法战胜猴子、豹子和海豚,但是在整场比赛中,人类就可以同时完成这三个项目。我们人类在感知事物的时候通常也是多感官同时发挥作用,相互协调和多次验证来加深对于外界物体的感知认识。更为复杂的事,我们甚至还要借助记忆、推理等理性认知能力来对感知事物进行加工,从而得到更为复杂的认知。

相比较于人类的多感官应用,机器人的单一感知或者简单组合的感知能力,又因为目前机器人的感知识别模式仍然是基于算法模型对于感知数据的分析和数据对比,因此难以产生更为复杂的推理知识,因此是机器人在认知的复杂度上稍逊于人类,但在识别物体的准确度和规模上就会远超人类。

现在,多模态感知融合的推进,将使得机器人在认知复杂度上面逐渐接近人类的能力。未来的机器人面对照明和遮挡、噪声和混响、运动和相似等复杂交互场景,将会变得更加游刃有余,从而产生各种收益明显的现实应用。

多模态感知融合可能应用到的领域,包括:

· 特殊化的精密操作领域。比如高难度外科手术领域,外科手术机器人可以通过对目标的精确观察和相关组织的分离、固定,进行比外科医生更精准的手术操作。

· 高危或者高难度的机器人作业。比如危险物品的搬运、拆除,比如普通人无法进入的管线等高难度区域检测检修,地下墓穴或海底的物品的搬运、打捞,通过机器听觉对密封空间的声音探测等。

像在安防、灾害救援、应急处理等需要灵活处理的场景,都可以逐渐交由多感知系统的机器人处理,或者人机协同远程处理。

此外,由于机器人感知融合能力的提高,机器人对于综合感知数据的训练,可以更好地理解人类本身的复杂性,尤其是可以建立更为复杂的情感计算模型,能够更好地理解人类在表情、声音、皮肤温度、肢体动作等方面传递出的情感信号,为更高级的人机互动提供新的可能。

目前来看,人工智能机器人仍然是一个复杂的系统工程,想要实现机器人的多模态感知融合,还需要对传感器性能、算法协同、多模态任务、环境测试等多方面进行综合研究。

这个过程必定是非常艰难的,但取得成果之后的前途必定是一片光明的。在我们期待人类与机器人和谐生活的未来,我们自然更期待这些机器人不再是一台冷冰冰的机器。

作者 脑极体

声明:本文内容和图片仅代表作者观点,不代表蓝时代网立场。蓝时代 » 机器视觉之外,机器人的感知补全计划

蓝时代

蓝时代